day 27 - large language models

(LLMs)

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 27 ديال سلسلة 30 يوم من التعلم الآلي..

أخيرًا،

جا الوقت باش ندويو على Large Language Models

بالعربية "نماذج اللغة الكبيرة"،

وهنايا فين كتزيان القضية

حيت هوما اللي trend دبا فعالم الذكاء الاصطناعي وخلقو ثورة عجيبة

هاد ChatGPT مبازي على LLM

LLM مبازي على Copilot

LLM مبازي على Gemini

واليوما غنشوفو LLMs

شنو يقدرو يديرو

وشنو (مزال) ميقدروش يديرو

اول حاجة بعدا

غشرحو شكايعني هاد "Large Language Models" في الواقع.

ديجا عارفين Large هي كبير (او ضخم)،

وف هذه الحالة اللي كبير هو عدد الخلايا العصبية neurons،

واللي كيتسماو أيضا parameters،

ف الشبكة العصبية مكاينش شي عدد محدد باش نقولو هادا راه Large Language Model

ولكن قول بلي خص العدد يفوت مليار خلية عصبية باش نعتبروها Large.

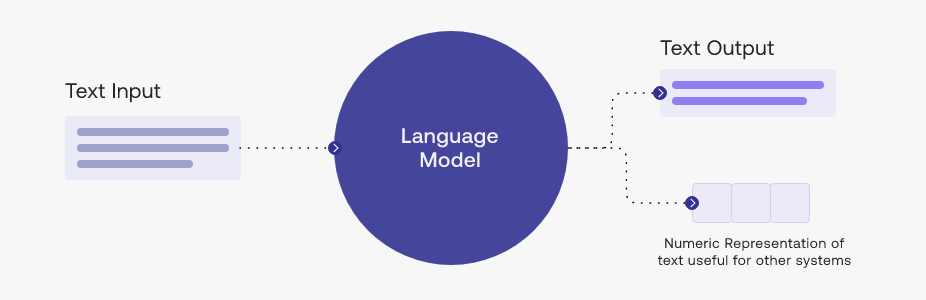

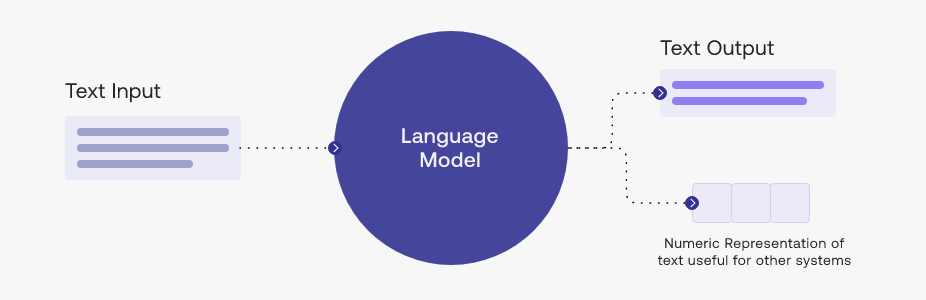

دبا شنو هو "نموذج اللغة" Language Model؟

ايلا شفتي ملي كتسول شات جي بي تي على شي حاجة

كيجاوبك ماشي نيشان ولكن حرف بحرف او كلمة بكلمة

هاد نموذج اللغة هو بكل بساطة: "تعلم التنبؤ بالكلمة التالية"

فالمثال اللي عندنا الفوق كنحاولو نجاوب على السؤال التالي..

شناهي الكلمة التالية ف تسلسل معين من الكلمات،

يغني ف جملة أو فقرة؟

بمعنى آخر،

بغينا نتعلمو كيفاش نتنبؤو بالكلمة التالية ف أي وقت.

غتقوليا هدشي ديجا شفناه مع الشبكات العصبية neural networks

نعم عندك الحق..

راه هاد LLMs غير واحد النوع من الشبكات العصبية..

اللي مصمم باش يدير معالجة النصوص وبيانات اللغة..

أي LLM راه Neural Network

ولكن ماشي أي LLM راه Neural Network

نماذج اللغات الكبيرة (LLMs) هي نماذج ذكاء اصطناعي

كتستخدم ف مجال معالجة اللغة الطبيعية.

هاد النماذج كتعتابر من أحدث التقنيات ف مجال توليد وفهم النصوص،

حيث كيخدمو بشبكات عصبية عميقة لتعلم الأنماط والترتيبات ف اللغة.

هاد LLMs كيعتمدو على مفهوم "التعلم بالإشراف supervised"،

ف تدريب training ديالها كنعطيوها كميات ضخمة من البيانات الموجودة فالانترنت.

وفاش كنقول ضخمة.. راه ضخمة نيييييت ايكا الحال

كتكون الداتا عبارة عن نصوص مكتوبة ف لغات مختلفة،

و LLMs كتقوم بالتحليل والفهم ديال هاد النصوص

باش تخرج المعاني والأنماط منها.

وبلاتي؟.. كتقول ليا النصوص Text واش غي text اللي خدام هنايا؟

وي.. LLMs خدام فالنصوص بوحدهم

وهدا هو الغلط اللي كيطيحو فيه بزاف ديال الناس (منهم انا نيت هه)

هاداك اللي كتشوف ف MidJourney و Sora و اي حاجة كتجينيري ليك تصاور وفيديوات واصوات..

هاداك سميتو Generative AI

ماشي Large Language Model

هاد Generative AI كيخرج ليك محتوى جديد متنوع ماشي غير النصوص،

بحال التصاور والموسيقى والكود.

من ناحية أخرى،

تم تصميم LLMs باش يفهم ويعطي نص كيشبه لديال بنادم..

بخلاصة.. هاد LLM غير نوع او مثال داخل فالمجال ديال Generative AI

احسن مثال نقدر نعطيه هو ChatGPT

ولكن راه السيت هو اللي سميتو ChatGPT ماشي المودل

المودل هو GPT (Generative Pre-trained Transformer)

وعندو اصدارات

GPT-2 .. GPT-3 .. GPT-3.5 Turbo … GPT-4 …

شنو هو هاد GPT؟

وعلاش سماوه ChatGPT وماشي ChatLLM؟

ديجا شفنا "generative" -

بمعنى أنه تدرب باش يجينيري لينا بيانات نصية جديدة،

انشوفو دبا P وT؟

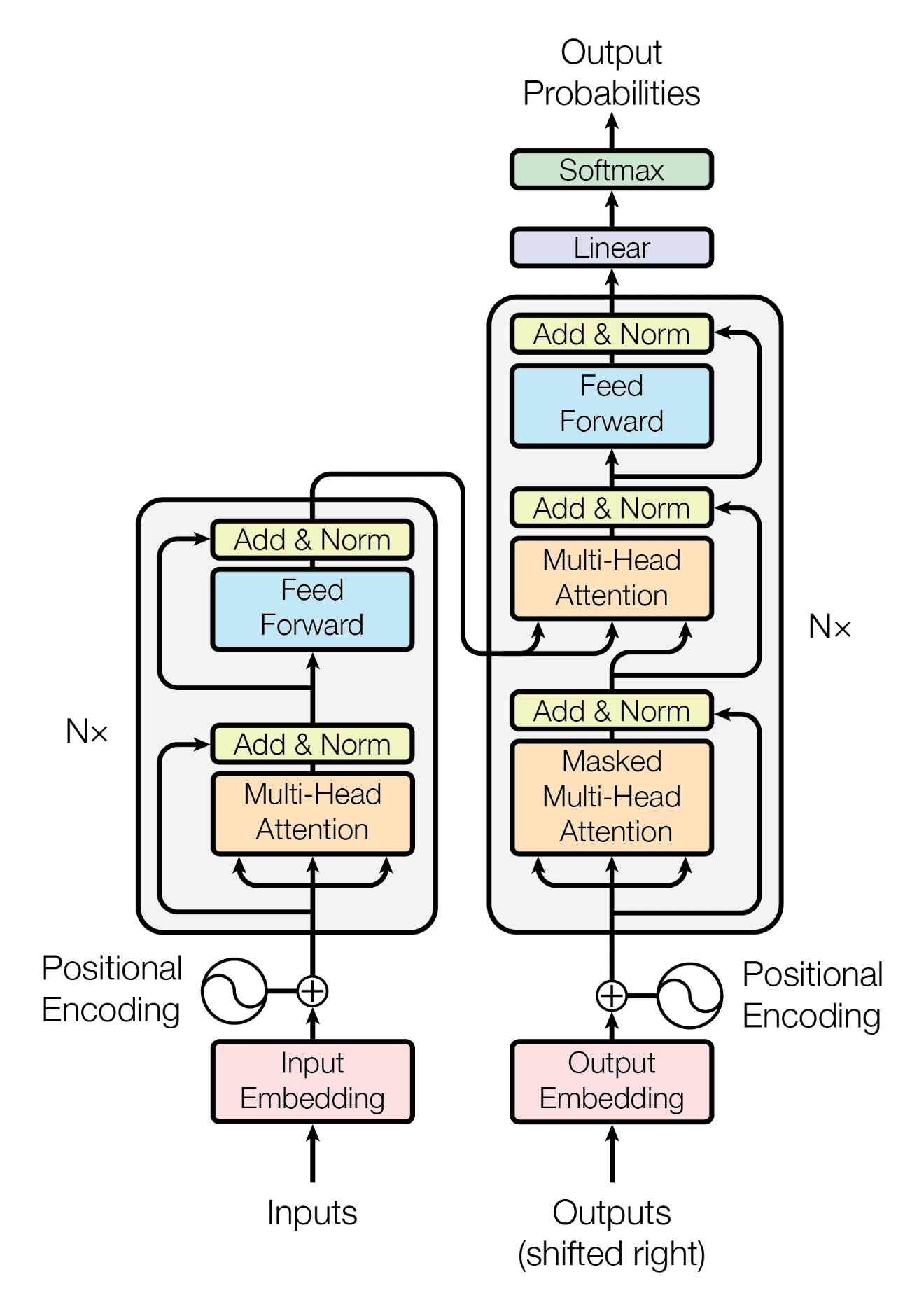

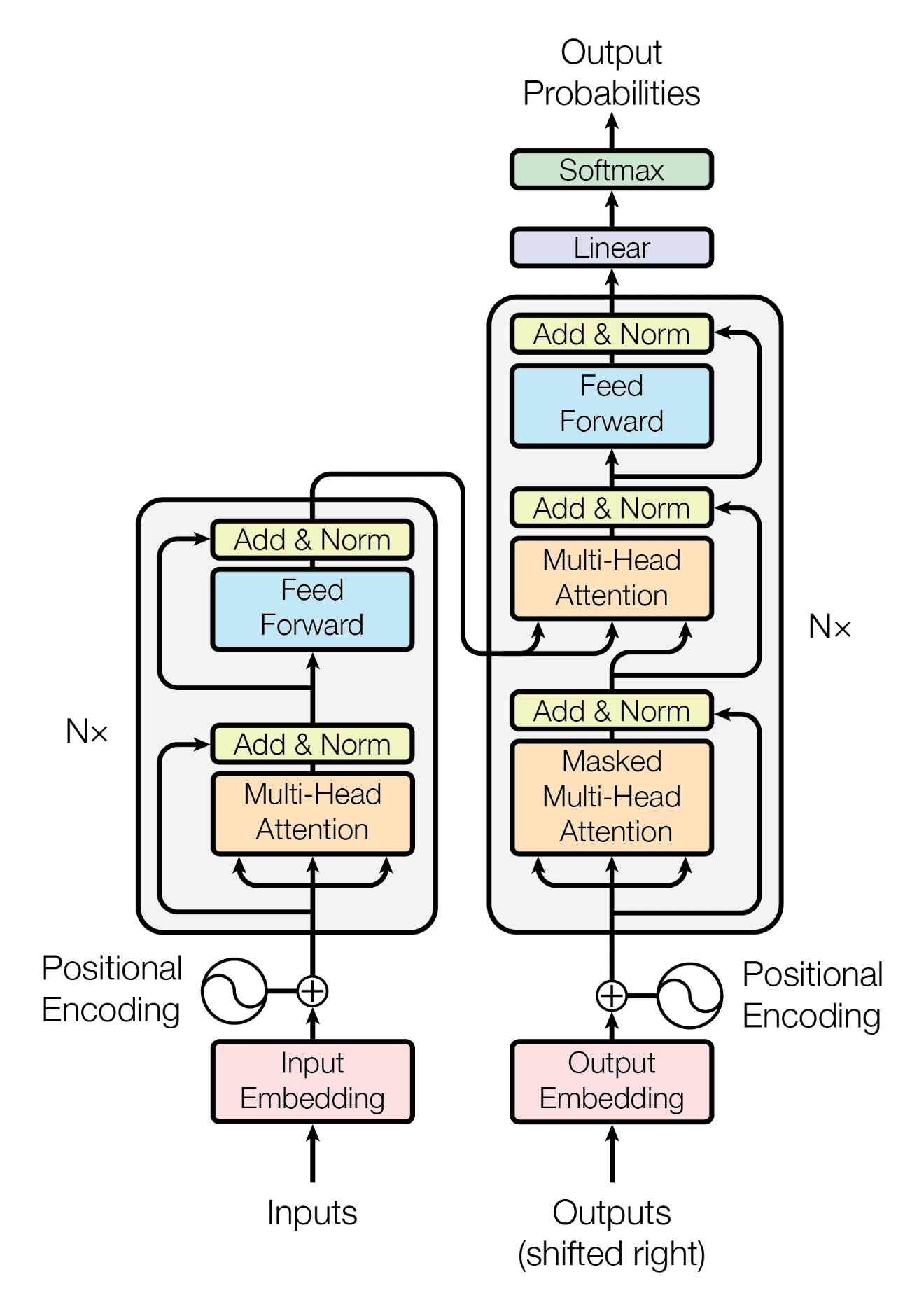

بالنسبة ل T كيرمز إلى "المحول Transformer"

لا ماشي هذا الاخوان

هو هدا

هدا كيخلع كثر ياك ههه

متخافوش هدا غير واحد النوع ديال بنية الشبكة العصبية اللي كتستخدم هنايا Neural Network Architecture

وايلا دوينا technically راه هي أهم حاجة فهادشي كامل

وبسبابها خرج لينا هاد التطور الخارق فالذكاء الاصطناعي

إيلا كنتي فضولي وبغيتي تعرف point fort ديالها،

فهي أن البنية ديال المحولات كتخدم مزيان حسن من الانواع الاخرين

حيتاش كتقدر تركز الاهتمام ديالها على الأجزاء الهامة من التسلسل ديال النص اللي كيدخل ك input ف أي وقت.

وهاد الاهتمام هو اللي كيتسمى Attention و Self-Attention

انشوفوه غدا كثر ان شاء الله

بقا لينا حرف P

واللي هو Pre-trained

مكنبقاوش نقولو trained ولكن ديجا معلم

كيفاش البلان؟

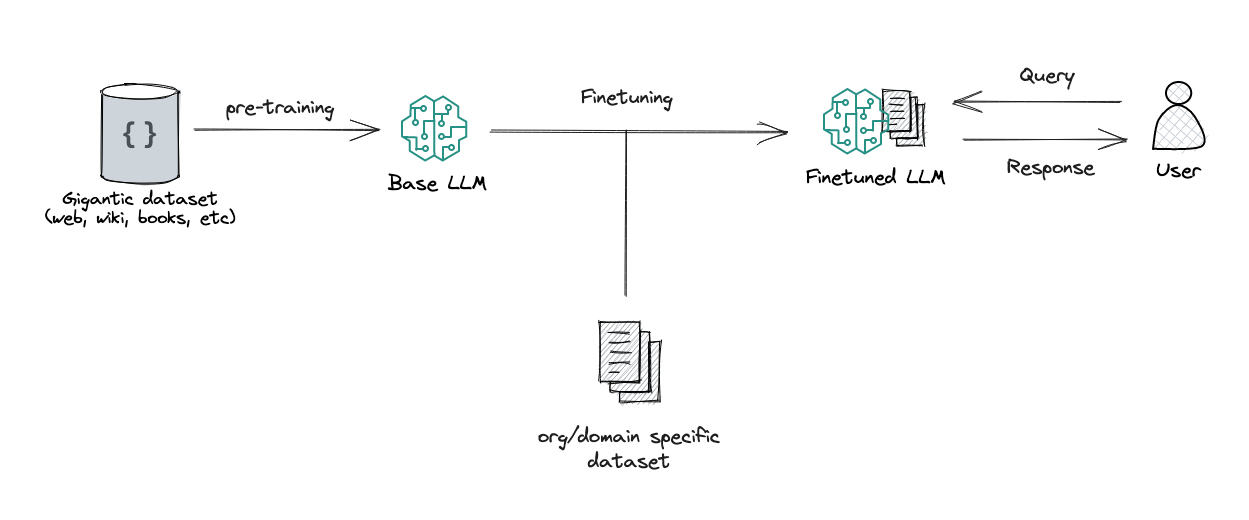

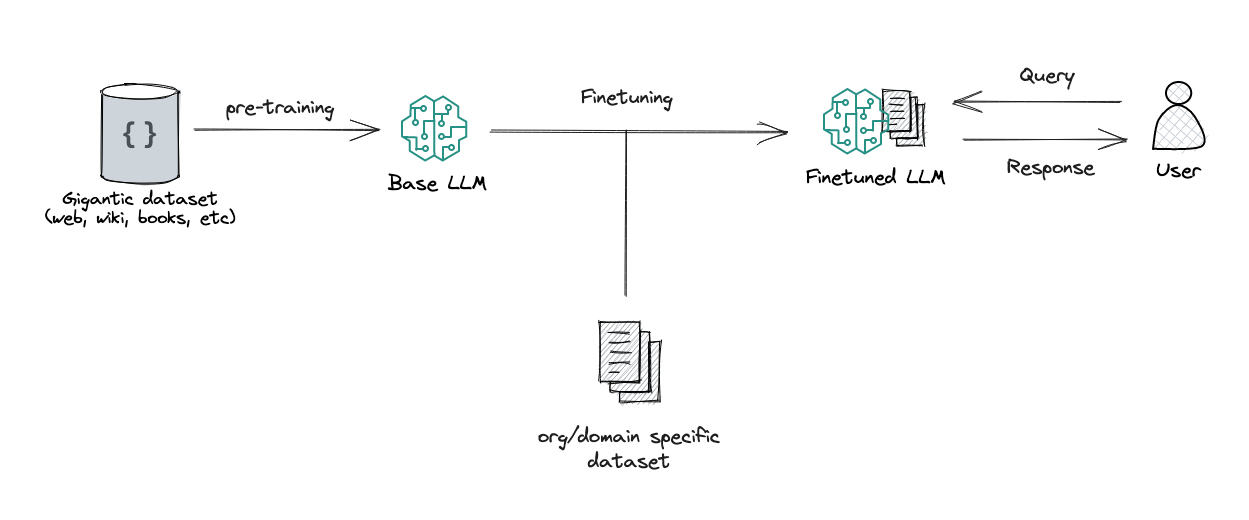

التدريب ديال نموذج اللغة الكبير (LLM) كيدوز من 3 مراحل رئيسية:

التدريب المسبق Pre-training:

ف هاد المرحلة، كيتم التدريب ديال النموذج على مجموعة كبيرة من البيانات النصية.

الهدف هو تعلم الأنماط الإحصائية للغة.

وهدشي كيكون بطريقة غير خاضعة للرقابة unsupervised،

مما يعني أن النموذج كيتعلم التنبؤ بالكلمة التالية في الجملة

بدون أي تسميات صريحة.

مثلا عندنا جملة "جلست القطة على ___"،

كيتعلم النموذج التنبؤ بكلمة "السجادة" أو "الكرسي"

أو أي كلمة معقولة أخرى تقدر تكمل الجملة.

هاد المرحلة كتعطينا نموذج لغة "مُدرب مسبقًا Pre-trained".

الضبط الدقيق Fine-Tuning:

من بعد التدريب المسبق، كيتم التدريب ديال النموذج بشكل أكبر على مجموعة بيانات أصغر ومحددة.

غالبا كتكون الداتاسيت ديجا labeled ،

وكيتم تدريب النموذج على أداء مهمة محددة،

بحال تحليل المشاعر (واش هاد التويت سعيد او حزين)

أو الإجابة على الأسئلة أو إنشاء النص.

هنايا داك المودل اللي ديجا تعلم من الداتا

كتعلمو انه يجاوبك على الأسئلة والمهام اللي كتطلب ليه

هادا هو Fine-tuning

تعزيز التعلم من ردود الفعل البشرية (RLHF):

من بعد مكتسالي الضبط الدقيق،

كيتم تقييم أداء النموذج من طرف الناس اللي كيعطيو ردود الفعل.

يعني Feedback

غتكون لاحظتي فاش كتعطي لشات جي بي تي سؤال وكيجاوبك..

كيقوليك حدا الجواب "واش عجبك الجواب؟ ايلا معجبكش او بان ليك فيه شي خطأ قولها لينا وعمر هاد الفورم"

ونتا كتكتب شي تعليق فحالة كان الجواب فيه شي حاجة ماهياش

هاد التعليقات كتعاون فإنشاء نموذج ديال المكافأة.

من بعد كيدار تحديث للمودل كامل باش يتحسنو دوك المكافآت

وهدشي باستخدام التعلم المعزز Reinforcement learning.

هاد العملية كتكرر بزاف ديال المرات،

كل مرة كيستافدو من ردود الافعال ديال الناس

كيحسنو المودل ديالهم وكيعاودو يديرو تحديث

وهكا غادا..

البروسيس مكيساليش

راه ماشي غير GPT اللي كاين

كاين BERT LLAMA PALM CLAUDE…

ولكن اوجه لعملة واحدة..

هاد الموضوع ديال LLM فيييييه ميتقال

ومدويتش على كلشي فيه

ولكن كنتمنى هاد الشوية اللي قلت يزعمكم تمشيو تقراو عليه كثر

راه حلو حلو والله

واحسن حاجة فهاد البلان كامل

هو انه تقدر تخدم ب LLM وخا متكونش محترف فهاد الدومين

ضرب طليلة على hugging face

هاد السيت فيه بزاف ديال المودلز حطوهم ناس وشركات باش نتا تخدم بيهم

كتلقاهم ديجا واجدين معلمين Pre-trained

ايلا بغيتي تعرف كثر على هاد البلان

تفرج فهاد الفيديو من غوغل فيه غير 5 دقايق

خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 27 ديال سلسلة 30 يوم من التعلم الآلي..

أخيرًا،

جا الوقت باش ندويو على Large Language Models

بالعربية "نماذج اللغة الكبيرة"،

وهنايا فين كتزيان القضية

حيت هوما اللي trend دبا فعالم الذكاء الاصطناعي وخلقو ثورة عجيبة

هاد ChatGPT مبازي على LLM

LLM مبازي على Copilot

LLM مبازي على Gemini

واليوما غنشوفو LLMs

شنو يقدرو يديرو

وشنو (مزال) ميقدروش يديرو

اول حاجة بعدا

غشرحو شكايعني هاد "Large Language Models" في الواقع.

ديجا عارفين Large هي كبير (او ضخم)،

وف هذه الحالة اللي كبير هو عدد الخلايا العصبية neurons،

واللي كيتسماو أيضا parameters،

ف الشبكة العصبية مكاينش شي عدد محدد باش نقولو هادا راه Large Language Model

ولكن قول بلي خص العدد يفوت مليار خلية عصبية باش نعتبروها Large.

دبا شنو هو "نموذج اللغة" Language Model؟

ايلا شفتي ملي كتسول شات جي بي تي على شي حاجة

كيجاوبك ماشي نيشان ولكن حرف بحرف او كلمة بكلمة

هاد نموذج اللغة هو بكل بساطة: "تعلم التنبؤ بالكلمة التالية"

فالمثال اللي عندنا الفوق كنحاولو نجاوب على السؤال التالي..

شناهي الكلمة التالية ف تسلسل معين من الكلمات،

يغني ف جملة أو فقرة؟

بمعنى آخر،

بغينا نتعلمو كيفاش نتنبؤو بالكلمة التالية ف أي وقت.

غتقوليا هدشي ديجا شفناه مع الشبكات العصبية neural networks

نعم عندك الحق..

راه هاد LLMs غير واحد النوع من الشبكات العصبية..

اللي مصمم باش يدير معالجة النصوص وبيانات اللغة..

أي LLM راه Neural Network

ولكن ماشي أي LLM راه Neural Network

نماذج اللغات الكبيرة (LLMs) هي نماذج ذكاء اصطناعي

كتستخدم ف مجال معالجة اللغة الطبيعية.

هاد النماذج كتعتابر من أحدث التقنيات ف مجال توليد وفهم النصوص،

حيث كيخدمو بشبكات عصبية عميقة لتعلم الأنماط والترتيبات ف اللغة.

هاد LLMs كيعتمدو على مفهوم "التعلم بالإشراف supervised"،

ف تدريب training ديالها كنعطيوها كميات ضخمة من البيانات الموجودة فالانترنت.

وفاش كنقول ضخمة.. راه ضخمة نيييييت ايكا الحال

كتكون الداتا عبارة عن نصوص مكتوبة ف لغات مختلفة،

و LLMs كتقوم بالتحليل والفهم ديال هاد النصوص

باش تخرج المعاني والأنماط منها.

وبلاتي؟.. كتقول ليا النصوص Text واش غي text اللي خدام هنايا؟

وي.. LLMs خدام فالنصوص بوحدهم

وهدا هو الغلط اللي كيطيحو فيه بزاف ديال الناس (منهم انا نيت هه)

هاداك اللي كتشوف ف MidJourney و Sora و اي حاجة كتجينيري ليك تصاور وفيديوات واصوات..

هاداك سميتو Generative AI

ماشي Large Language Model

هاد Generative AI كيخرج ليك محتوى جديد متنوع ماشي غير النصوص،

بحال التصاور والموسيقى والكود.

من ناحية أخرى،

تم تصميم LLMs باش يفهم ويعطي نص كيشبه لديال بنادم..

بخلاصة.. هاد LLM غير نوع او مثال داخل فالمجال ديال Generative AI

احسن مثال نقدر نعطيه هو ChatGPT

ولكن راه السيت هو اللي سميتو ChatGPT ماشي المودل

المودل هو GPT (Generative Pre-trained Transformer)

وعندو اصدارات

GPT-2 .. GPT-3 .. GPT-3.5 Turbo … GPT-4 …

شنو هو هاد GPT؟

وعلاش سماوه ChatGPT وماشي ChatLLM؟

ديجا شفنا "generative" -

بمعنى أنه تدرب باش يجينيري لينا بيانات نصية جديدة،

انشوفو دبا P وT؟

بالنسبة ل T كيرمز إلى "المحول Transformer"

لا ماشي هذا الاخوان

هو هدا

هدا كيخلع كثر ياك ههه

متخافوش هدا غير واحد النوع ديال بنية الشبكة العصبية اللي كتستخدم هنايا Neural Network Architecture

وايلا دوينا technically راه هي أهم حاجة فهادشي كامل

وبسبابها خرج لينا هاد التطور الخارق فالذكاء الاصطناعي

إيلا كنتي فضولي وبغيتي تعرف point fort ديالها،

فهي أن البنية ديال المحولات كتخدم مزيان حسن من الانواع الاخرين

حيتاش كتقدر تركز الاهتمام ديالها على الأجزاء الهامة من التسلسل ديال النص اللي كيدخل ك input ف أي وقت.

وهاد الاهتمام هو اللي كيتسمى Attention و Self-Attention

انشوفوه غدا كثر ان شاء الله

بقا لينا حرف P

واللي هو Pre-trained

مكنبقاوش نقولو trained ولكن ديجا معلم

كيفاش البلان؟

التدريب ديال نموذج اللغة الكبير (LLM) كيدوز من 3 مراحل رئيسية:

التدريب المسبق Pre-training:

ف هاد المرحلة، كيتم التدريب ديال النموذج على مجموعة كبيرة من البيانات النصية.

الهدف هو تعلم الأنماط الإحصائية للغة.

وهدشي كيكون بطريقة غير خاضعة للرقابة unsupervised،

مما يعني أن النموذج كيتعلم التنبؤ بالكلمة التالية في الجملة

بدون أي تسميات صريحة.

مثلا عندنا جملة "جلست القطة على ___"،

كيتعلم النموذج التنبؤ بكلمة "السجادة" أو "الكرسي"

أو أي كلمة معقولة أخرى تقدر تكمل الجملة.

هاد المرحلة كتعطينا نموذج لغة "مُدرب مسبقًا Pre-trained".

الضبط الدقيق Fine-Tuning:

من بعد التدريب المسبق، كيتم التدريب ديال النموذج بشكل أكبر على مجموعة بيانات أصغر ومحددة.

غالبا كتكون الداتاسيت ديجا labeled ،

وكيتم تدريب النموذج على أداء مهمة محددة،

بحال تحليل المشاعر (واش هاد التويت سعيد او حزين)

أو الإجابة على الأسئلة أو إنشاء النص.

هنايا داك المودل اللي ديجا تعلم من الداتا

كتعلمو انه يجاوبك على الأسئلة والمهام اللي كتطلب ليه

هادا هو Fine-tuning

تعزيز التعلم من ردود الفعل البشرية (RLHF):

من بعد مكتسالي الضبط الدقيق،

كيتم تقييم أداء النموذج من طرف الناس اللي كيعطيو ردود الفعل.

يعني Feedback

غتكون لاحظتي فاش كتعطي لشات جي بي تي سؤال وكيجاوبك..

كيقوليك حدا الجواب "واش عجبك الجواب؟ ايلا معجبكش او بان ليك فيه شي خطأ قولها لينا وعمر هاد الفورم"

ونتا كتكتب شي تعليق فحالة كان الجواب فيه شي حاجة ماهياش

هاد التعليقات كتعاون فإنشاء نموذج ديال المكافأة.

من بعد كيدار تحديث للمودل كامل باش يتحسنو دوك المكافآت

وهدشي باستخدام التعلم المعزز Reinforcement learning.

هاد العملية كتكرر بزاف ديال المرات،

كل مرة كيستافدو من ردود الافعال ديال الناس

كيحسنو المودل ديالهم وكيعاودو يديرو تحديث

وهكا غادا..

البروسيس مكيساليش

راه ماشي غير GPT اللي كاين

كاين BERT LLAMA PALM CLAUDE…

ولكن اوجه لعملة واحدة..

هاد الموضوع ديال LLM فيييييه ميتقال

ومدويتش على كلشي فيه

ولكن كنتمنى هاد الشوية اللي قلت يزعمكم تمشيو تقراو عليه كثر

راه حلو حلو والله

واحسن حاجة فهاد البلان كامل

هو انه تقدر تخدم ب LLM وخا متكونش محترف فهاد الدومين

ضرب طليلة على hugging face

هاد السيت فيه بزاف ديال المودلز حطوهم ناس وشركات باش نتا تخدم بيهم

كتلقاهم ديجا واجدين معلمين Pre-trained

ايلا بغيتي تعرف كثر على هاد البلان

تفرج فهاد الفيديو من غوغل فيه غير 5 دقايق

خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

التالي