day 19 - how do neural networks

work

day 19 -

how do neural networks

work

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 19 ديال سلسلة 30 يوم من التعلم الآلي..

شفنا شنو هوما neurons والمكونات ديالها

شفنا شناهي activation function وكيفاش كتخدم

اليوم غنجمعو هادشي كامل

وغادي نعرفو الخطوات اللي كتدوز منهم الشبكة العصبية

باش تعلم وتعطيك نتائج اللي بغيتي

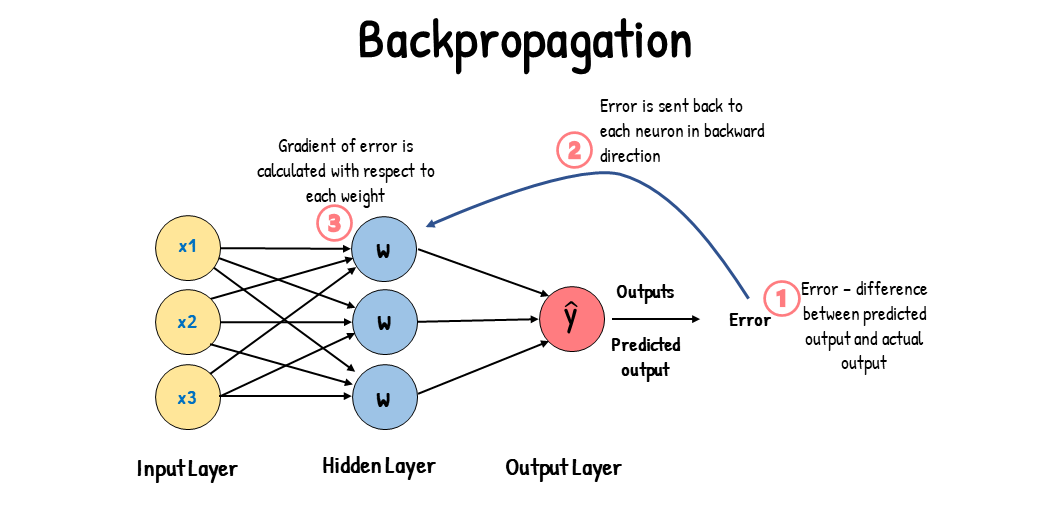

شفتي هاد الرسم بزاف دلمرات وقيلا طلع ليك فراسك ماشي مشكل اتعاود تشوفو اليوم

هادي شبكة عصبية بسيطة

عندك فاليسار واحد الصف من متغيرات الادخال input variables

الاسهم اللي كيمشيو من المتغيرات لداك العصبون فالوسط هما الاوزان weights

وعلى اليمين عندك النتيجة المتوقعة ŷ او قيمة الاخراج output

وكاينة واحد القيمة التحت y هاديك هي القيمة او النتيجة الحقيقية

دبا داك الفرق بين y و ŷ هو علاياش داير الفيلم كامل

فاش كيمشيو المدخلات وكيدخلو مع الاوزان وكيدوزو لدالة التنشيط،

فالاخر كتعطينا النتيجة اللي هي ŷ

باش الشبكة العصبية ديالنا تتعلم،

كيخصنا نديرو مقارنة بين النتيجة اللي خرجات لينا،

والنتيجة الحقيقية اللي عندنا

وباش كنحسبو الفرق، كنطبقو واحد الدالة سميتها دالة التكلفة cost function (كتسمى حتى loss function)

هاد الدالة هي اللي كتعطينا نسبة الخطأ فالتوقع ديالنا

الهدف ديالنا هو نحاولو نصغرو القيمة ديال loss function

قدما كانت القيمة منخفضة،

قدما كانو ŷ و y قراب لبعضياتهم،

يعني القيمة اللي توقعناها والقيمة الحقيقية غيبقاو يتقاربو..

وبالتالي غتكون الشبكة العصبية ديالنا عندها دقة مزيانة

هاد loss function عندها بزاف ديال الانواع،

كتخدم على حساب هديك اللي مسلكا المشكل ديالك

هاد البروسيس كامل من تغذية الشبكة بالبيانات حتى توقع قيمة ŷ كيتسمى forward propagation

مع كنحسبو loss function، كنرجعو للوراء

كنديرو اعادة التدوير

كنمشيو وكنعاودو نفس الخطوات ولكن كنبدلو فالاوزان weights،

كنديرو اوزان جداد وكنعاودو نخدمو الشبكة،

كتدير نفس الخدمة وكتوصل ل loss function كنحسبوها

وكتبقا هكا تبدل فالاوزان طالما كاين داك التباين بين y و ŷ

هاد البروسيس ديال ترجع باللور كيتسمى backpropagation

ودوك الخطوات كيبقاو يتطبقو لواحد العدد من المرات

حتى كتدرب الشبكة بشكل كافي

وكيتقلل الخطا لواحد الحد ادنى عاد كتحبس..

مثلا ايلا كانت loss function هي 2^(y - ŷ)

خاص نحاولو ما أمكن ندربو الشبكة حتى نوصلوها ل 0 أو أقرب قيمة ل 0

هاد العدد من المرات اللي كيتعاود فيهم هاد البروسيس كيتسمى epochs

اذن كاين

run a neural network = (forward propagation + backpropagation) * epochs

هكا كيتعلم neural network

شوف هاد المثال:

تخيل عندنا 3 ديال input values

عدد ساعات الدراسة

عدد ساعات النوم

شحال جبتي فالمراقبة المستمرة CC

وبغينا نتوقعو النتيجة ديال واحد الامتحان النهائي اللي مزال مدوزنا

نقولو مثلا بلي النتيجة الحقيقية اللي عندنا هي 93%

دوك المتغيرات الثلاثة كندخلوهوم للشبكة ديالنا

وكنطبقو عليهم الاوزان ودالة التنشيط

من بعد كتخرج لينا نتيجة ŷ كنحسبو بيها cost function ديالنا باش نعرفو واش هاد ŷ مزيانة اولا لا

ايلا كان اختلاف وتباين بين y و ŷ كنعاودو نبدلو الاوزان وكنعاودو الحساب حتى كنصغرو ديك cost function

وهاد اللعيبة كتطبق شحال من مرة على بزاف ديال العينات

كل سطر عندها شبكة ديالها كتطبق forward/backward propagation

باش فالاخر يتجمع ويتشكل ليك واحد الشبكة عصبية اللي كبيرة

انشوفو كثر backpropagation وكيفاش دوك weights كيتبدلو فايمايلات جايين ان شاء الله

هادا بعجالة هو كيفاش كيخدم neural networks

كنتمنى نكون وصلت الفكرة وانكم فهمتو ولو شوية

حيث هاد الكونصيبت ماشي ساهل تفهمو مزيان من البدية

ولكن كتولف مع الوقت..

هادي خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

مصادر:

The Ultimate Guide to Artificial Neural Networks (ANN)

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 19 ديال سلسلة 30 يوم من التعلم الآلي..

شفنا شنو هوما neurons والمكونات ديالها

شفنا شناهي activation function وكيفاش كتخدم

اليوم غنجمعو هادشي كامل

وغادي نعرفو الخطوات اللي كتدوز منهم الشبكة العصبية

باش تعلم وتعطيك نتائج اللي بغيتي

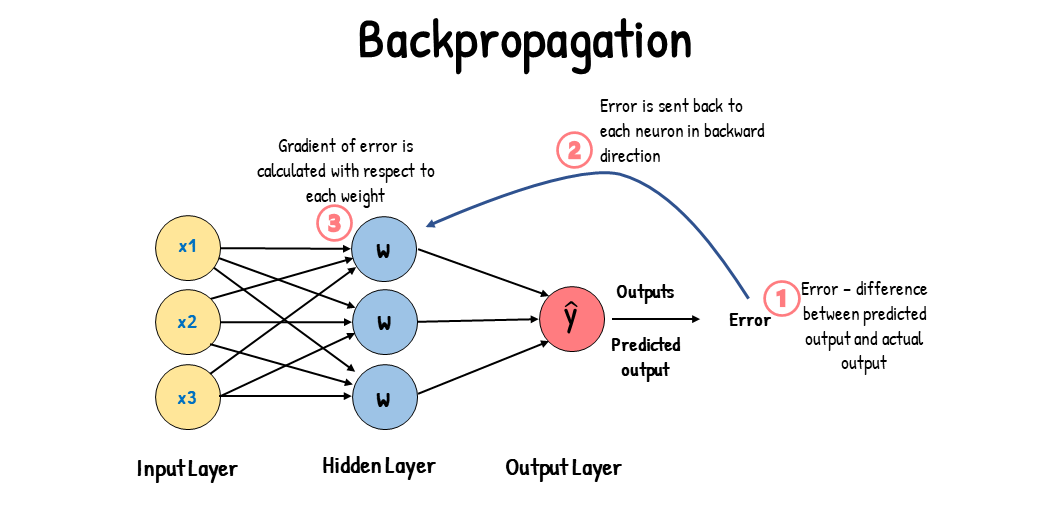

شفتي هاد الرسم بزاف دلمرات وقيلا طلع ليك فراسك ماشي مشكل اتعاود تشوفو اليوم

هادي شبكة عصبية بسيطة

عندك فاليسار واحد الصف من متغيرات الادخال input variables

الاسهم اللي كيمشيو من المتغيرات لداك العصبون فالوسط هما الاوزان weights

وعلى اليمين عندك النتيجة المتوقعة ŷ او قيمة الاخراج output

وكاينة واحد القيمة التحت y هاديك هي القيمة او النتيجة الحقيقية

دبا داك الفرق بين y و ŷ هو علاياش داير الفيلم كامل

فاش كيمشيو المدخلات وكيدخلو مع الاوزان وكيدوزو لدالة التنشيط،

فالاخر كتعطينا النتيجة اللي هي ŷ

باش الشبكة العصبية ديالنا تتعلم،

كيخصنا نديرو مقارنة بين النتيجة اللي خرجات لينا،

والنتيجة الحقيقية اللي عندنا

وباش كنحسبو الفرق، كنطبقو واحد الدالة سميتها دالة التكلفة cost function (كتسمى حتى loss function)

هاد الدالة هي اللي كتعطينا نسبة الخطأ فالتوقع ديالنا

الهدف ديالنا هو نحاولو نصغرو القيمة ديال loss function

قدما كانت القيمة منخفضة،

قدما كانو ŷ و y قراب لبعضياتهم،

يعني القيمة اللي توقعناها والقيمة الحقيقية غيبقاو يتقاربو..

وبالتالي غتكون الشبكة العصبية ديالنا عندها دقة مزيانة

هاد loss function عندها بزاف ديال الانواع،

كتخدم على حساب هديك اللي مسلكا المشكل ديالك

هاد البروسيس كامل من تغذية الشبكة بالبيانات حتى توقع قيمة ŷ كيتسمى forward propagation

مع كنحسبو loss function، كنرجعو للوراء

كنديرو اعادة التدوير

كنمشيو وكنعاودو نفس الخطوات ولكن كنبدلو فالاوزان weights،

كنديرو اوزان جداد وكنعاودو نخدمو الشبكة،

كتدير نفس الخدمة وكتوصل ل loss function كنحسبوها

وكتبقا هكا تبدل فالاوزان طالما كاين داك التباين بين y و ŷ

هاد البروسيس ديال ترجع باللور كيتسمى backpropagation

ودوك الخطوات كيبقاو يتطبقو لواحد العدد من المرات

حتى كتدرب الشبكة بشكل كافي

وكيتقلل الخطا لواحد الحد ادنى عاد كتحبس..

مثلا ايلا كانت loss function هي 2^(y - ŷ)

خاص نحاولو ما أمكن ندربو الشبكة حتى نوصلوها ل 0 أو أقرب قيمة ل 0

هاد العدد من المرات اللي كيتعاود فيهم هاد البروسيس كيتسمى epochs

اذن كاين

run a neural network = (forward propagation + backpropagation) * epochs

هكا كيتعلم neural network

شوف هاد المثال:

تخيل عندنا 3 ديال input values

عدد ساعات الدراسة

عدد ساعات النوم

شحال جبتي فالمراقبة المستمرة CC

وبغينا نتوقعو النتيجة ديال واحد الامتحان النهائي اللي مزال مدوزنا

نقولو مثلا بلي النتيجة الحقيقية اللي عندنا هي 93%

دوك المتغيرات الثلاثة كندخلوهوم للشبكة ديالنا

وكنطبقو عليهم الاوزان ودالة التنشيط

من بعد كتخرج لينا نتيجة ŷ كنحسبو بيها cost function ديالنا باش نعرفو واش هاد ŷ مزيانة اولا لا

ايلا كان اختلاف وتباين بين y و ŷ كنعاودو نبدلو الاوزان وكنعاودو الحساب حتى كنصغرو ديك cost function

وهاد اللعيبة كتطبق شحال من مرة على بزاف ديال العينات

كل سطر عندها شبكة ديالها كتطبق forward/backward propagation

باش فالاخر يتجمع ويتشكل ليك واحد الشبكة عصبية اللي كبيرة

انشوفو كثر backpropagation وكيفاش دوك weights كيتبدلو فايمايلات جايين ان شاء الله

هادا بعجالة هو كيفاش كيخدم neural networks

كنتمنى نكون وصلت الفكرة وانكم فهمتو ولو شوية

حيث هاد الكونصيبت ماشي ساهل تفهمو مزيان من البدية

ولكن كتولف مع الوقت..

هادي خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

مصادر:

The Ultimate Guide to Artificial Neural Networks (ANN)

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

التالي