day 26 - dimensionality reduction

(PCA..)

enjoy the

background music

0:00/1:34

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 26 ديال سلسلة 30 يوم من التعلم الآلي..

نزولا عند رغبة بعض الاصدقاء

غنرجعو نشوفو واحد الحاجة اللي قليل اللي كيدوي عليها

ولكن فالحقيقة راه مهمة بزاف وخص اي فقيه بيانات يعرفها

واللي هي Dimensionality Reduction

بالعربية "تقليل الأبعاد"

تخيل أنك خدام ف شي بروجي ديال التنبؤ بثمن الديور.

ناري رجعنا للمثال الاسطوري ههه

عندك واحد الداتاسيت فيها بزاف ديال الميزات -

فيها عدد غرف النوم والحمامات،

الحجم ديالها,

السنوات اللي دوزات,

شحال من عائلة دازت على ديك الدار,

عندك نوع الأرضيات،

واش المرحاض ديالها رومي اولا بلدي,

المسافة من أقرب مدرسة….

وزيد وزيد..

كاينين شي features هنايا مفيدين فالتوقع،

وكاينين اللي مغيفيدش بزاف فالمودل اللي غنقاد

بالعكس..

يقدرو يردو الأداء ديالو أسوأ وأكفس. (بحال نوع المرحاض 💀)

هنايا فين كيجي الدور ديال "تقليل الأبعاد".

تقليل الأبعاد هو واحد الأسلوب كيقلل من عدد متغيرات الإدخال في مجموعة البيانات

بحال فاش كتبسط شي وصفة ديال طبخ معقدة

وكتركز على المكونات التي كتساهم بشكل أكبر ف النكهة.

علاش هاد dimensionality reduction مهم لهاد الدرجة؟

التعامل مع البيانات عالية الأبعاد (high-dimensional data)

كتكون صعيبة بزاف لعدة أسباب.

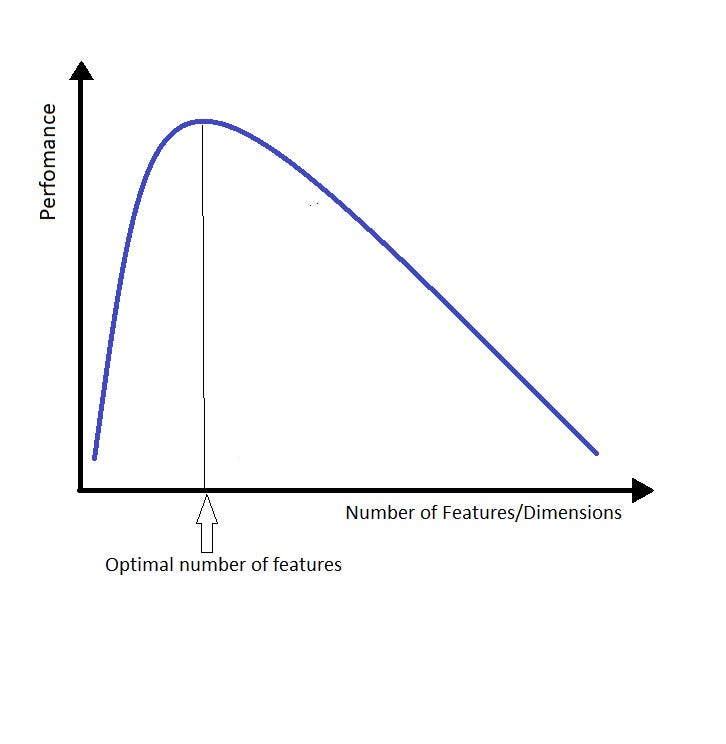

أصلا هاد الظاهرة معروفة كتسمى "لعنة الأبعاد"

Curse of Dimensionality

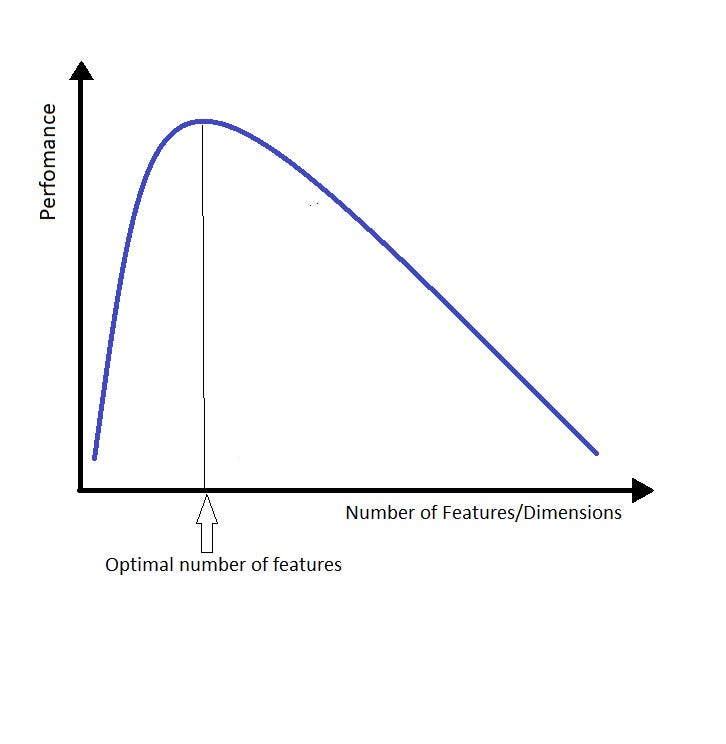

قدما تزادو الميزات (الأبعاد).. قدما زاد التعقيد ديال المودل

وقدما نقص الاداء والفعالية

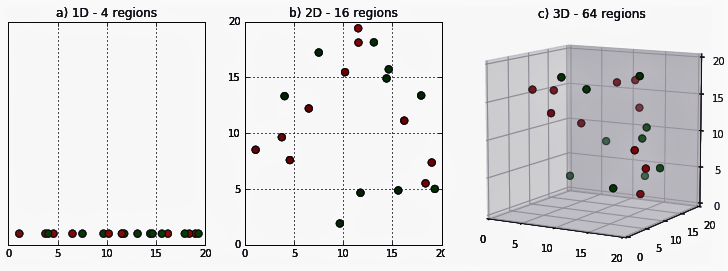

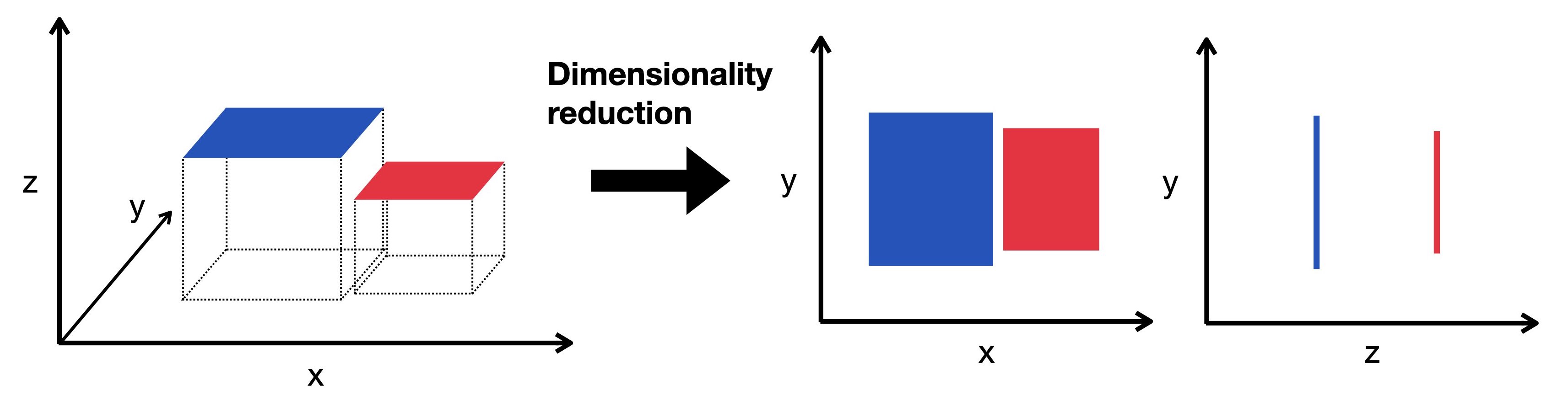

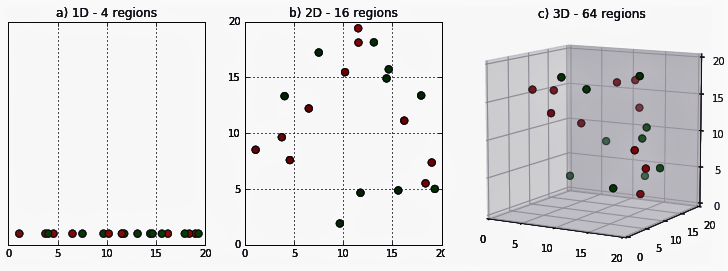

هدشي كيبان غير ايلا رسمنا مثلا هاد الداتاسيت فمعلم

السطورا ديال Math و Reading هما الfeatures ديالنا

ايلا درنا غير Math ودرناها فمعلم غيخرج لينا الرسم a اللي التحت

ايلا زدنا Reading غيولي عندنا الرسم ثنائي الأبعاد b

اللي الافصول ديالو غيكون Math والارتوب هو Reading مثلا

ايلا زدنا feature اخرى (مثلا Writing)

القضية كتعقد

و غنخرجو ف رسم ثلاثي الابعاد 3D… هو الرسم c

قبل متزيد شي feature اخرى

هاد الصورة التحت كتمثل الفضاء رباعي الأبعاد 4D

ملي غتشوفها غتعرف بلي مبلانش ههه

لحسن الحظ عندنا Dimensionality Reduction

تقليل عدد الأبعاد غادي يسهل علينا نديرو تصور البيانات

data visualization

وغتنقص حتى الحجم ديال الذاكرة memory المطلوبة لتخزين البيانات،

وغتحيد عليك داك التشويش noise ودوك irrelevant features.

كاينين 2 أنواع ديال تقليل الأبعاد:

اختيار الميزة Feature Selection

واستخراج الميزة Feature Extraction

Feature Selection

اختيار الميزة هو اختيار مجموعة فرعية من الميزات الأصلية اللي أكثر صلة بالمشكلة المطروحة.

الهدف منها هو تقليل أبعاد الداتاسيت مع الاحتفاظ بالميزات الأكثر أهمية.

كاينين عدة طرق باش يدار Feature Selection

كاين طرق التصفية filter methods،

وطرق التغليف wrapper methods،

وطرق التضمين embedded methods.

طرق التصفية كترتب الميزات بناءً على المدى ديال الصلة والعلاقة ديالها بالمتغير المستهدف target variable،

طرق التغليف كتعتامد الأداء ديال المودل كمعيار باش تختار الميزات،

و الطرق المضمنة كتجمع بين اختيار الميزات وعملية تدريب المودل.

Feature Extraction

استخراج الميزات هو إنشاء ميزات جديدة من خلال دمج الميزات الأصلية أو تحويلها.

الهدف ديالها هو نقادو مجموعة من الميزات اللي كتجسد الجوهر ديال البيانات الأصلية ف مساحة بأبعاد أقل.

يعني كيكون عندنا نفس الخصائص ديال الداتا ولكن فابعاد اصغر.

شنو هما الطرق باش ندير هاد تقليل الأبعاد؟

مغندويش عليهم كاملين

ولكن غنشير لطريقتان شائعتان

وكل وحدة غنحط ليكم فيديو عليها كيشرح بالتفصيل

هاد 2 طرق هما تحليل المكونات الرئيسية (PCA) والتحليل التمييزي الخطي (LDA).

Principal Component Analysis (PCA)

تحليل المكونات الرئيسية (PCA) هي طريقة إحصائية

كتحلل خصائص / ميزات مجموعة البيانات

وكتلخص الميزات الأكثر تأثيرًا فالداتا ديالنا.

كيتجمعو features ديالنا تمثيلات كتحافظ على معظم خصائص البيانات

ولكن كتنتشر عبر أبعاد أقل.

بمعنى "كتقلص" البيانات من تمثيل بُعد أعلى إلى تمثيل ذي أبعاد قليلة فقط.

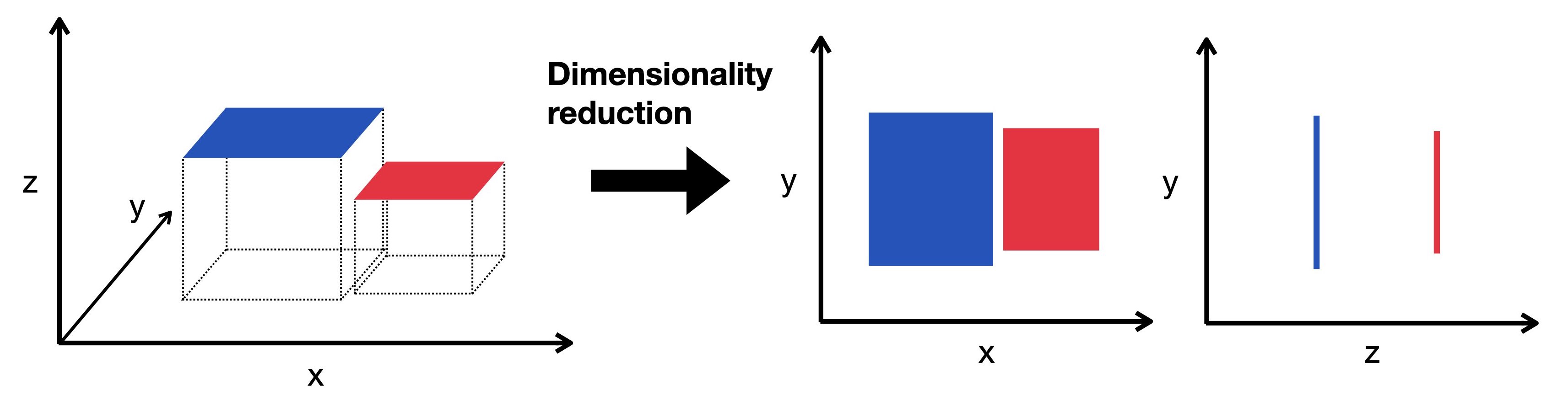

كيما كتشوفو فالرسم على الليسر شوف الداتا كيفاش مجموعة ولكن كاينة ف رسم ثلاثي البعد

هاد كيحاول ينقص من البعد و يخلي للداتا نفس الفورما ومعظم الخصائص اللي ديجا كانو فيها

القضية فيها شوية ديال statistics

ولكن باش تفهمو مزيان تفرجو فهاد الفيديو عندو شرح سهل ومفصل

ومخلا ليا منقول تحية لسي Josh Starmer

Linear Discriminant Analysis (LDA)

تحليل التمييز الخطي (LDA) هي واحد العملية كتاخذ فيها البيانات من رسم بياني متعدد الأبعاد

و كتعاود تحطهم ف رسم بياني خطي.

يعني كتردهم غير فخط كيولي المبيان عندو بعد واحد.

هاد الخط كيكون فيه جميع نقاط البيانات موزعين عليه

وكيتقسم إلى قسمين باش نلقاو أفضل فصل ممكن للبيانات.

حتا هنايا فيه الماط ههه

شوفو هاد الفيديو من نفس الشخص راه كلشي واضح عندو

هاد 2 لي شفنا كيتسماو Linear Methods

كاينين لي Non-Linear واللي كيتسماو Manifold Learning

وفيهم Kernel PCA

t-SNE

Isomap

…

كاينين طرق اخرين بحال SVD و Auto-Encoders

ولكن هدشي شويا متقدم

مفهمتيش شي حاجة غوغليها :)

هكا غتعلم وغتفهم كثر..

بالنسبة ل unsupervised machine learning

كنستعملو PCA،

و ف supervised كتكون عادةً LDA وPCA.

هاد الخوارزميات هي ببساطة طرق إحصائية..

غير statistics

و الاستخدام ديالها كيكون خارج نماذج التعلم الآلي.

ايلا كنتي عاد بادي متهزش ليها الهم..

مزيان بعدا ملي عرفتيها معانا هنا

ايلا كنتي مهتم.. قرا وقلب اعمق عليها راه تستاهل

ايلا حسيتي براسك مشديتيش هدشي مزيان

هانية..

عرف غير بلي تقليل الابعاد كيقلل عدد الfeatures فالداتا

باش نقدرو نديرو ملاحظات احسن

ونتوقعو نتائج افضل باستعمال اهم الميزات فالداتا

هدا ماكان على Dimensionality Reduction

خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

السلام عليكم ورحمة الله... معاكم Kaito :)

مرحبا بيكم فالنهار 26 ديال سلسلة 30 يوم من التعلم الآلي..

نزولا عند رغبة بعض الاصدقاء

غنرجعو نشوفو واحد الحاجة اللي قليل اللي كيدوي عليها

ولكن فالحقيقة راه مهمة بزاف وخص اي فقيه بيانات يعرفها

واللي هي Dimensionality Reduction

بالعربية "تقليل الأبعاد"

تخيل أنك خدام ف شي بروجي ديال التنبؤ بثمن الديور.

ناري رجعنا للمثال الاسطوري ههه

عندك واحد الداتاسيت فيها بزاف ديال الميزات -

فيها عدد غرف النوم والحمامات،

الحجم ديالها,

السنوات اللي دوزات,

شحال من عائلة دازت على ديك الدار,

عندك نوع الأرضيات،

واش المرحاض ديالها رومي اولا بلدي,

المسافة من أقرب مدرسة….

وزيد وزيد..

كاينين شي features هنايا مفيدين فالتوقع،

وكاينين اللي مغيفيدش بزاف فالمودل اللي غنقاد

بالعكس..

يقدرو يردو الأداء ديالو أسوأ وأكفس. (بحال نوع المرحاض 💀)

هنايا فين كيجي الدور ديال "تقليل الأبعاد".

تقليل الأبعاد هو واحد الأسلوب كيقلل من عدد متغيرات الإدخال في مجموعة البيانات

بحال فاش كتبسط شي وصفة ديال طبخ معقدة

وكتركز على المكونات التي كتساهم بشكل أكبر ف النكهة.

علاش هاد dimensionality reduction مهم لهاد الدرجة؟

التعامل مع البيانات عالية الأبعاد (high-dimensional data)

كتكون صعيبة بزاف لعدة أسباب.

أصلا هاد الظاهرة معروفة كتسمى "لعنة الأبعاد"

Curse of Dimensionality

قدما تزادو الميزات (الأبعاد).. قدما زاد التعقيد ديال المودل

وقدما نقص الاداء والفعالية

هدشي كيبان غير ايلا رسمنا مثلا هاد الداتاسيت فمعلم

السطورا ديال Math و Reading هما الfeatures ديالنا

ايلا درنا غير Math ودرناها فمعلم غيخرج لينا الرسم a اللي التحت

ايلا زدنا Reading غيولي عندنا الرسم ثنائي الأبعاد b

اللي الافصول ديالو غيكون Math والارتوب هو Reading مثلا

ايلا زدنا feature اخرى (مثلا Writing)

القضية كتعقد

و غنخرجو ف رسم ثلاثي الابعاد 3D… هو الرسم c

قبل متزيد شي feature اخرى

هاد الصورة التحت كتمثل الفضاء رباعي الأبعاد 4D

ملي غتشوفها غتعرف بلي مبلانش ههه

لحسن الحظ عندنا Dimensionality Reduction

تقليل عدد الأبعاد غادي يسهل علينا نديرو تصور البيانات

data visualization

وغتنقص حتى الحجم ديال الذاكرة memory المطلوبة لتخزين البيانات،

وغتحيد عليك داك التشويش noise ودوك irrelevant features.

كاينين 2 أنواع ديال تقليل الأبعاد:

اختيار الميزة Feature Selection

واستخراج الميزة Feature Extraction

Feature Selection

اختيار الميزة هو اختيار مجموعة فرعية من الميزات الأصلية اللي أكثر صلة بالمشكلة المطروحة.

الهدف منها هو تقليل أبعاد الداتاسيت مع الاحتفاظ بالميزات الأكثر أهمية.

كاينين عدة طرق باش يدار Feature Selection

كاين طرق التصفية filter methods،

وطرق التغليف wrapper methods،

وطرق التضمين embedded methods.

طرق التصفية كترتب الميزات بناءً على المدى ديال الصلة والعلاقة ديالها بالمتغير المستهدف target variable،

طرق التغليف كتعتامد الأداء ديال المودل كمعيار باش تختار الميزات،

و الطرق المضمنة كتجمع بين اختيار الميزات وعملية تدريب المودل.

Feature Extraction

استخراج الميزات هو إنشاء ميزات جديدة من خلال دمج الميزات الأصلية أو تحويلها.

الهدف ديالها هو نقادو مجموعة من الميزات اللي كتجسد الجوهر ديال البيانات الأصلية ف مساحة بأبعاد أقل.

يعني كيكون عندنا نفس الخصائص ديال الداتا ولكن فابعاد اصغر.

شنو هما الطرق باش ندير هاد تقليل الأبعاد؟

مغندويش عليهم كاملين

ولكن غنشير لطريقتان شائعتان

وكل وحدة غنحط ليكم فيديو عليها كيشرح بالتفصيل

هاد 2 طرق هما تحليل المكونات الرئيسية (PCA) والتحليل التمييزي الخطي (LDA).

Principal Component Analysis (PCA)

تحليل المكونات الرئيسية (PCA) هي طريقة إحصائية

كتحلل خصائص / ميزات مجموعة البيانات

وكتلخص الميزات الأكثر تأثيرًا فالداتا ديالنا.

كيتجمعو features ديالنا تمثيلات كتحافظ على معظم خصائص البيانات

ولكن كتنتشر عبر أبعاد أقل.

بمعنى "كتقلص" البيانات من تمثيل بُعد أعلى إلى تمثيل ذي أبعاد قليلة فقط.

كيما كتشوفو فالرسم على الليسر شوف الداتا كيفاش مجموعة ولكن كاينة ف رسم ثلاثي البعد

هاد كيحاول ينقص من البعد و يخلي للداتا نفس الفورما ومعظم الخصائص اللي ديجا كانو فيها

القضية فيها شوية ديال statistics

ولكن باش تفهمو مزيان تفرجو فهاد الفيديو عندو شرح سهل ومفصل

ومخلا ليا منقول تحية لسي Josh Starmer

Linear Discriminant Analysis (LDA)

تحليل التمييز الخطي (LDA) هي واحد العملية كتاخذ فيها البيانات من رسم بياني متعدد الأبعاد

و كتعاود تحطهم ف رسم بياني خطي.

يعني كتردهم غير فخط كيولي المبيان عندو بعد واحد.

هاد الخط كيكون فيه جميع نقاط البيانات موزعين عليه

وكيتقسم إلى قسمين باش نلقاو أفضل فصل ممكن للبيانات.

حتا هنايا فيه الماط ههه

شوفو هاد الفيديو من نفس الشخص راه كلشي واضح عندو

هاد 2 لي شفنا كيتسماو Linear Methods

كاينين لي Non-Linear واللي كيتسماو Manifold Learning

وفيهم Kernel PCA

t-SNE

Isomap

…

كاينين طرق اخرين بحال SVD و Auto-Encoders

ولكن هدشي شويا متقدم

مفهمتيش شي حاجة غوغليها :)

هكا غتعلم وغتفهم كثر..

بالنسبة ل unsupervised machine learning

كنستعملو PCA،

و ف supervised كتكون عادةً LDA وPCA.

هاد الخوارزميات هي ببساطة طرق إحصائية..

غير statistics

و الاستخدام ديالها كيكون خارج نماذج التعلم الآلي.

ايلا كنتي عاد بادي متهزش ليها الهم..

مزيان بعدا ملي عرفتيها معانا هنا

ايلا كنتي مهتم.. قرا وقلب اعمق عليها راه تستاهل

ايلا حسيتي براسك مشديتيش هدشي مزيان

هانية..

عرف غير بلي تقليل الابعاد كيقلل عدد الfeatures فالداتا

باش نقدرو نديرو ملاحظات احسن

ونتوقعو نتائج افضل باستعمال اهم الميزات فالداتا

هدا ماكان على Dimensionality Reduction

خلاصة اليوم:

نتلاقاو فايمايل اخر غدا!

كنتمنى تكونو استافدتو.. ايلا عندكم شي تساؤل اولا مشرحتش شي حاجة مزيان، غير صيفط ليا رد فهاد المايل نيت..

— Kaito

ملاحظات:

ايلا عاجبك هدشي وقادر باش تساند هاد newsletter بدعم مادي

دخل لهنا: https://ko-fi.com/callmekaito

شكرا (:

التالي